перевод статьи Utkarsh Kulshrestha – Feature Selection & Feature Engineering

Признаки, также известные как измерения, независимые переменные, столбцы в разрезе Data Science. Выбор и обработка этих признаков является одной из важнейших составляющих построения любой модели машинного обучения. Различные методологии доступны для использования признаков, которые, в свою очередь, напрямую влияют на точность, точность и полноту для моделей машинного обучения. Идея здесь состоит в том, чтобы понять эти методы в деталях, чтобы сделать лучшую модель.

Выбор признаков

Выбор признаков – это, в основном, методы, применяемые к набору данных для определения потенциально важных признаков из набора данных, которые оказывают сильное влияние на зависимую переменную. Преимущества выбора признаков – оптимизированный набор данных, низкое потребление памяти, улучшенная производительность модели и т. д.

- Экспертиза домена: это ручной метод определения важных переменных в данных с помощью анализа домена или бизнес-эксперта. Эксперт по домену может дать представление о бизнесе, в котором аналитик может понять и определить важные признаки или, если аналитику повезло, он может сразу получить именно те важные признаки, которые необходимы для построения модели.

- Пропущенные значения: интересен случай пропущенных значений. Какой бы столбец объектов не содержал более 40% -50% пропущенных значений, эти столбцы можно сразу отбрасывать, потому что вменение с помощью теоремы о центральной тенденции здесь не поможет. Остальные признаки будут использованы для целей моделирования.

- Корреляция: когда независимые элементы связаны друг с другом, возникает проблема коллинеарности. Проще говоря, корреляция нарушает баланс весов, сгенерированный моделью во время обучения. Коэффициент корреляции рассчитывается по формуле Пирсона:

Диапазон R лежит в диапазоне от -1 до +1, где -1 указывает на совершенно отрицательную корреляцию, ноль указывает на отсутствие корреляции, а +1 указывает на совершенно положительную корреляцию.

- Мультиколлинеарность. Мультиколлинеарность – это еще одна форма корреляции, где значения лежат между минус бесконечностью и плюс бесконечностью, что может сильно повлиять на расчеты коэффициента регрессионной модели. Это можно проверить с помощью VIF (вариационного фактора инфляции), который можно интерпретировать как:

1 = не коррелирует; От 1 до 5 = умеренно коррелированный; > 5 = высоко коррелированный

- Проверка нулевой дисперсии: если какие-либо признаки имеют нулевую дисперсию, эти признаки необходимо отбросить, поскольку эти признаки не позволяют модели обобщать данные или не обеспечивают никакой связи между независимыми и зависимыми переменными.

-

Деривация элементов: признаки могут быть получены из существующего признака, также называемого разделением признаков. Например, столбец, состоящий из времени и даты (дд / мм / гг чч: мм: сс), можно разделить на две отдельные функции, такие как дата и время. Точно так же два признака могут быть объединены, чтобы создать новый отдельный признак вместо двух. Например, один столбец содержит цену продажи, а другой – себестоимость, поэтому новый признак, называемый прибылью, может быть получен путем объединения этих двух признаков и может использоваться непосредственно для построения модели вместо двух признаков.

Конструирование признаков

Конструирование признаков – это в основном методологии, применяемые к признакам для их обработки определенным образом, когда конкретная модель машинного обучения сможет их использовать. Конструирование признаков или обработка признаков помогает уменьшить переобучение, недообучение, оптимизировать веса и т. д.

- Нормализация: Это метод для перевода данных в определенный масштаб, или Нормализация обычно означает масштабирование переменной до значений от 0 до 1.

min-max скаляр для нормализации - Стандартизация: Это опять-таки наиболее часто используемый метод масштабирования объектов, который нормализует данные таким образом, что вновь сгенерированное распределение будет иметь среднее значение 0 и стандартное отклонение как 1. Формула для стандартизации также называется формулой Z-Score, которая преобразует Нормальное распределение в стандартное нормальное распределение.

Z-score И нормализация, и стандартизация являются методами масштабирования, но при выборе одного из них необходимо соблюдать осторожность, так как на нормализацию влияют выбросы, тогда как на стандартизацию не влияют выбросы, и она считается подходящим методом масштабирования в аналитической отрасли. -

Логарифмическое преобразование: это еще один метод нормализации данных. Он сводит данные в определенный диапазон. Эти преобразования обычно используются для искаженных данных, так чтобы более высокие величины концентрировались в центре.

логарифмическоепреобразование - Кодирование признаков: используется для преобразования категориальных признаков в числовые значения с использованием различных методов кодирования. Наиболее часто используемые методологии кодирования признаков, используемые в индустрии аналитики, – это кодирование в одно касание, ортогональное кодирование, фиктивное кодирование и т. д.

Кодирование в одно касание (one-hot)

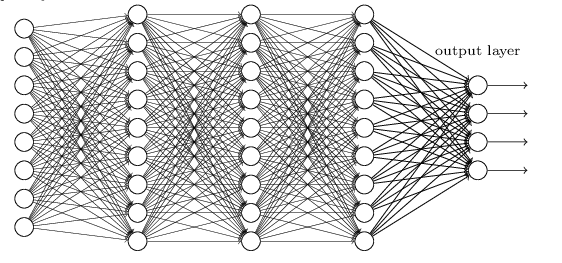

Ортогональное кодирование - Анализ главных компонентов: широко известный как PCA – это метод, используемый для уменьшения размеров. Он принимает все функции, коррелированные или некоррелированные, и генерирует новые признаки, называемые главными компонентами, которые ортогональны друг другу или некоррелированы по своей природе. PCA следует использовать только тогда, когда число параметров большое.

-

Вменение данных: пропущенные значения в столбцах могут быть вменены с помощью центральной теоремы тенденции. Для числовых функций можно использовать среднее и медианное значение, а для категориальных функций – режим, позволяющий рассчитать нулевые значения. Помимо этих нескольких методов также доступны другие, такие как нулевое заполнение, обратное заполнение, прямое заполнение и т. д.

Оригинал статьи:

https://medium.com/analytics-vidhya/feature-selection-feature-engineering-3bb09c67d8c5